Dénis climatiques

L’histoire du déni de la catastrophe climatique débute en même temps que celle de son exploration scientifique. Les mêmes « marchands de doute » qui s’étaient successivement employés à minimiser les risques associés au tabagisme, aux pluies acides et à l’hiver nucléaire ont à nouveau exploité le problème épistémologique de l’incertitude—inhérente à toute entreprise de connaissance— d’abord afin de nier la réalité du réchauffement de la planète, puis pour occulter son incidence.

Le négationnisme climatique serait-il néanmoins en recul ? Jusqu’à une date récente, les plus optimistes ont pu le croire, quitte à se satisfaire des politiques de décarbonation fondées sur des mécanismes de prix incitatifs (taxe carbone, marchés de quotas d’émission) et destinées à internaliser les externalités écologiques du capitalisme fossile. Cependant, tant le dépassement récent du seuil de 1,5 °C fixé par l’Accord de Paris que la montée en puissance des droites radicales, tragiquement illustrée par le retour de Donald Trump à la présidence des États-Unis, suggèrent que l’annonce d’une conversion des élites politiques à la quête de la sobriété était pour le moins prématurée.

Pour rendre compte de la régression en cours, il convient d’abord d’inventorier les différentes formations discursives qui structurent le débat sur la question climatique. Or, en la matière, on constate que le sens commun se déplace rapidement vers la droite : longtemps dicté par les promoteurs d’un capitalisme vert, pour qui la transition vers un monde décarboné est aussi prioritaire que compatible avec la rentabilité des investissements, il semble désormais happé par les contempteurs de « l’écologie punitive » et, dans une moindre mesure, par les apôtres d’un environnementalisme néomalthusien prônant la souveraineté énergétique, la fermeture des frontières et le contrôle des naissances dans les pays du Sud.

Au niveau des déclarations d’intention, le verdissement sans peine excessive prôné par les avocats du Net Zéro est d’une tout autre nature que l’exhortation à Drill Baby Drill qui tient lieu de mot d’ordre à l’administration Trump. En pratique, cependant, les différences entre les deux approches sont souvent affaire de degrés : les rivalités qui président aux politiques industrielles menées par les États-Unis, l’Europe et la Chine mais aussi les logiques d’accumulation du capital dans les secteurs fossile et renouvelable tendent en effet à favoriser la subordination des impératifs de soutenabilité aux objectifs de sécurité, en particulier dans un contexte d’aiguisement des tensions géopolitiques et de réaménagement des alliances.

Marqué par l’essor d’une forme de carbo-cynisme, le point de bascule actuel appelle paradoxalement à autant de nuances que d’intransigeance : s’il ne peut être question de confondre les carences des COP avec la politique de la terre brûlée conduite par leurs ennemis, on se doit également de souligner les convergences entre la lucidité affectée par les uns et le négationnisme professé par les autres – notamment parce que les gouvernements ostensiblement sensibles à l’urgence climatique paraissent renoncer à la mitigation véritable que constitue le désengagement stratégique des actifs fossiles au profit d’une stratégie d’adaptation au réchauffement fondée sur la promotion de technologies aussi hasardeuses que la géo-ingénierie et la captation directe du dioxyde de carbone dans l’air.

La Fabrique du déni

Propos recueillis le 24 Septembre 2025

“Si vous supprimez les agences qui jouent un rôle crucial dans la mesure du changement climatique, vous n’avez même plus besoin de nier la science. Vous la détruisez, tout simplement. Il y a quelque chose de particulièrement agressif et tragique dans ce glissement vers un territoire orwellien.”

LE CONSENSUS DE WALL STREET

Propos recueillis le 11 Avril 2025

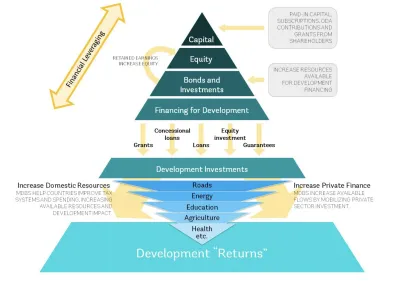

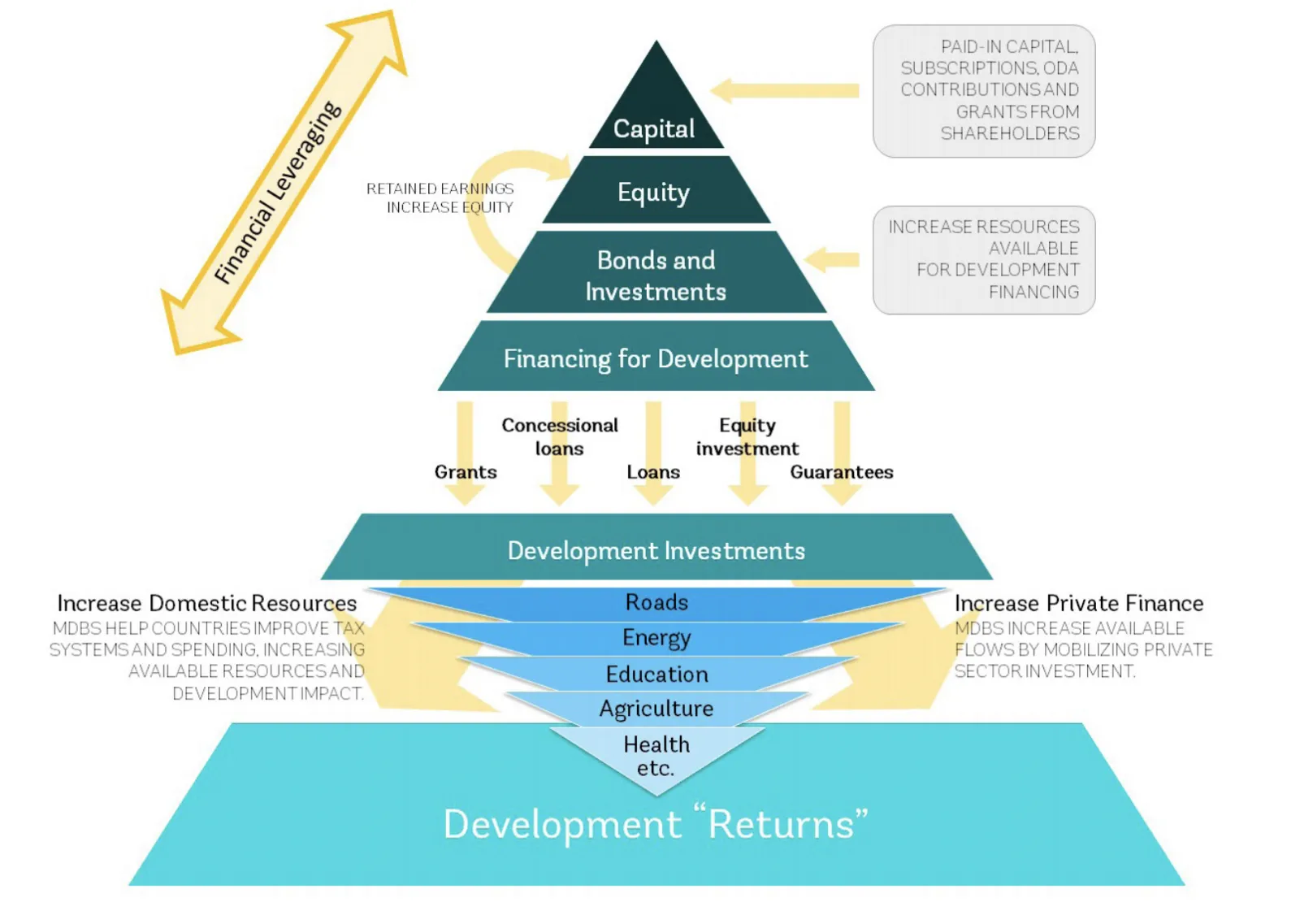

“C’est le récit du consensus de Wall Street : l’État ne peut générer assez de ressources fiscales et le secteur privé ne peut générer assez de retours pour les ambitions transformatrices de l’État. La logique du partenariat est donc de redistribuer les risques du secteur privé à l’État. Ainsi celui-ci rend plus attractifs pour le capital privé les investissements dans les secteurs jugés prioritaires, comme le développement, puis ça s’est étendu au climat, à la politique industrielle, à l’armement…”

EXTRACTIVISME, VERT ET BRUN

Propos recueillis le 14 Mars 2025

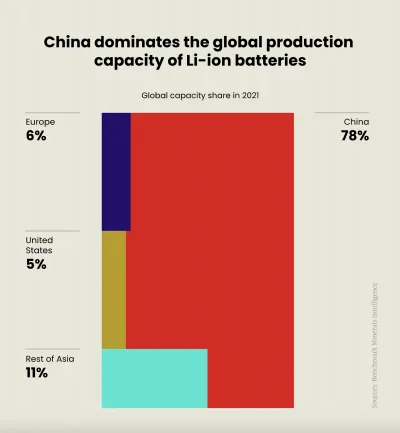

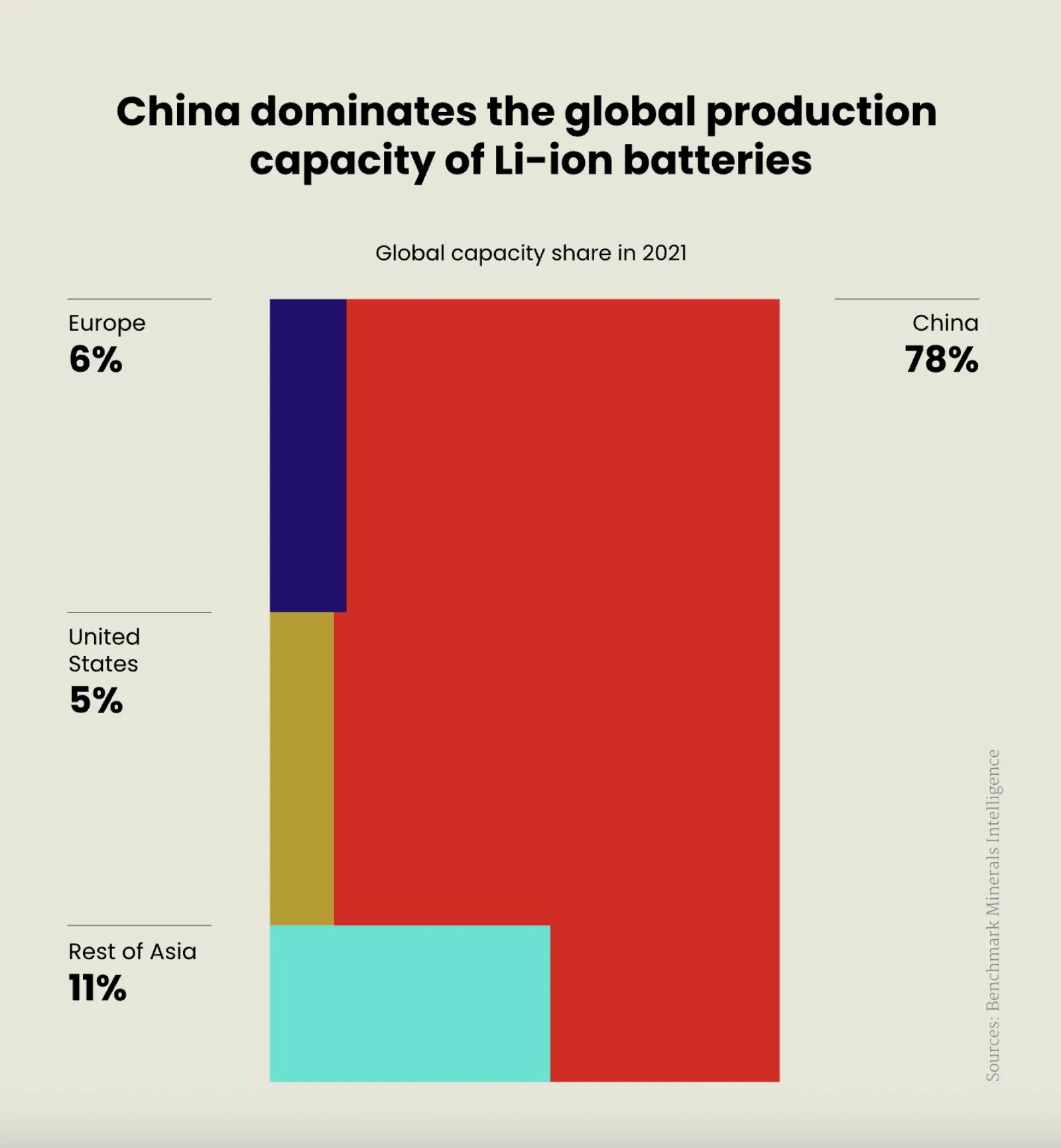

"Lorsque j’emploie le terme de capitalisme vert, je fais référence à un ensemble de forces productives déjà déployées, qui englobe à la fois des secteurs dont l’existence est justifiée par leur contribution supposée à l’effort de décarbonation – tels que la production de batteries au lithium ou d’aciers bas carbone – et des technologies non éprouvées, telles que la géo-ingénierie ou le captage et le stockage du carbone."

Portraits

Scott Bessent

Scott Bessent, actuel secrétaire au Trésor des États-Unis, n'avait pour toute expérience politique que la collecte de fonds qu'il a organisée pour Al Gore en 2000 avant d’intégrer l’administration Trump. En tant que gestionnaire de fonds spéculatifs, il a toutefois une certaine expérience des gouvernements, puisqu’on lui doit d’avoir “cassé” la Banque d'Angleterre en pariant contre la livre sterling en 1992. À l’époque, il était partenaire du Soros Management Fund et donc associé de Georges Soros, dont les activités philanthropiques figurent parmi les principales cibles des campagnes anti-wokedu MAGA, et dont le nom constitue un déclencheur de la haine antisémite au sein du mouvement.

Lorsqu’il quitte le Soros Management Fund, Scott Bessent cofonde, en 2015, le Key Square Group. C’est là qu’il embrasse plus résolument les causes libertariennes chères à la communauté des fonds spéculatifs. En 2024, il figure parmi les plus grands soutiens financiers de Donald Trump, faisant don d'un million de dollars au MAGA Super PAC et de 100 000 dollars à Right for America, un autre Super PAC trumpiste. Il organise également deux collectes de fonds pour sponsoriser la campagne du candidat républicain, l'une chez lui à Greenville, en Caroline du Sud, qui permet de récolter près de 7 millions de dollars, et l'autre à Palm Beach, en Floride, qui lève 50 millions de dollars.

Lors de son audition de confirmation, Bessent a fait l'éloge de la politique fiscale qu'il a été chargé de mettre en œuvre, et bien qu’il ne soit pas taillé pour le rôle, il s’est efforcé de lui donner une coloration populiste : “Si nous ne renouvelons pas ces réductions d’impôts, prévient-il, nous serons confrontés à une calamité économique et, comme toujours, à une instabilité financière qui touchera avant tout les classes moyennes et ouvrières”.

Le “jour de la libération”, la frénésie tarifaire de Donald Trump met Bessent visiblement mal à l’aise. Malgré tout, il s’applique discrètement à réconcilier les positions mercantilistes de son patron avec les préférences de Wall Street. D'où le discours, soigneusement élaboré, qu’il livre le 23 avril 2025, lors de la réunion de printemps du FMI, devant les représentants des principaux partenaires des États-Unis. Cherchant à les rassurer, il insiste sur le fait que le but de l’administration Trump n’est pas de détruire, mais plutôt de réformer les institutions internationales tels que le FMI et la Banque mondiale : “L'Amérique d'abord ne signifie pas l'Amérique seule”, soutient-il.

Dans le même temps, Scott Bessent n’a pas manqué de rappeler à son auditoire que l’heure était venue pour le FMI et la Banque mondiale de “prendre du recul par rapport à leurs programmes tentaculaires et non ciblés qui ont étouffé leur capacité à remplir leurs missions fondamentales”. Autrement dit, le FMI doit cesser de consacrer “un temps et des ressources disproportionnés au changement climatique, au genre et aux questions sociales", tandis que “la Banque mondiale doit répondre aux priorités et aux besoins énergétiques des pays en se concentrant sur des technologies fiables, aptes à soutenir la croissance économique, plutôt que de chercher à atteindre des objectifs de financement de la préservation du climat qui ne font que créer des distorsions”.

Hyman Minsky

Hyman Minsky naît à Chicago en 1919 et y grandit dans un milieu socialiste. Ses parents sont tous deux des Mencheviks juifs venus du Belarus après l’échec de la révolution de 1905. On raconte qu’ils se sont rencontrés aux États-Unis, lors d’une fête en l’honneur du centenaire de la naissance de Karl Marx. Après des études de mathématiques à l’université de Chicago et trois ans passés à travailler pour l’armée américaine en Europe – de 1943 à 1946 – le jeune Hyman entame son doctorat en économie à l’université de Harvard. Il travaille d’abord avec Joseph Schumpeter puis, après la mort de celui-ci, achève sa thèse sous la direction de Wassily Leontief. Son intérêt pour les processus cycliques doit beaucoup à ses deux mentors.

Aussi pénétré de la pensée de John Maynard Keynes – dont le Treatise on Probability l’a décidé à bifurquer vers l’économie politique – que rétif à la synthèse néo-keynésienne qui domine la discipline dans les premières décennies d’après-guerre, Minsky demeure un macroéconomiste relativement méconnu jusqu’au moment de gloire posthume que lui offre la crise financière de 2008. Celle-ci sera en effet appelée un “moment Minsky”, même si les mesures prises pour y répondre ont peu à voir avec ce qu’il recommandait. Guère écouté de son vivant, Minsky mène néanmoins une carrière universitaire honorable, enseignant successivement à la Brown University, à UC Berkeley et à la Washington University de Saint-Louis. Après sa retraite, il achève sa carrière de chercheur au Levy Institute de Bard, où il poursuivra ses travaux jusqu’à sa mort, en 1996.

Rangé parmi les économistes postkeynésiens, aux côtés de Michal Kalecki, Joan Robinson et Nicholas Kaldor, Minsky est l’auteur de deux livres : John Maynard Keynes, publié en 1975, où il s’empare du concept keynésien d’incertitude radicale pour récuser l’aseptisation de la Théorie générale de l’emploi, de l’intérêt et de la monnaie par les néo-keynésiens, et Stabiliser une économie instable, sorti en 1986, qui parachève son exploration du déséquilibre structurel dont la finance de marché affecte le capitalisme.

Les leçons que Minsky tire concurremment de son analyse de la crise de 1929 et du chapitre 12 de la Théorie générale sur la “prévision à long terme” s’inscrivent en faux contre l’hypothèse des anticipations rationnelles sur laquelle repose la microéconomie néoclassique – et que ses rivaux dans la constellation keynésienne reprennent largement à leur compte. Elles récusent en particulier l’idée que les agents économiques éprouvent une aversion au risque constante, c’est-à-dire indépendante de la conjoncture. Selon Minsky, la prise de décision dans un contexte d’incertitude radicale conduit au contraire à une alternance “procyclique” entre moments d’enthousiasme et d’inquiétude. Elle confère par conséquent un caractère irrémédiablement maniaco-dépressif aux marchés financiers.

Lorsqu’une économie capitaliste entame une période de croissance, explique le promoteur du “paradoxe de la tranquillité”, la confiance naissante incite les entreprises à investir, d’abord sur leurs fonds propres, mais ensuite en empruntant. Non moins enclins à l’optimisme, les prêteurs et autres investisseurs institutionnels répondent volontiers aux sollicitations dont ils font l’objet, gageant que l’audace des emprunteurs est le présage d’importants retours sur investissement pour eux. Dans un premier temps, toutefois, les interactions entre les firmes non financières et les pourvoyeurs de crédit demeurent dans le cadre de ce que Minsky appelle le stade de la “finance couverte” (hedge finance) : les premières se bornent à emprunter des sommes qu’elles sont en mesure de rembourser, et les secondes font preuve d’une même prudence dans l’octroi de leurs largesses.

Mais bientôt, le maintien des perspectives de croissance que semble signaler l’augmentation du cours des actions et de la valeur nominale des obligations va pousser les acteurs à prendre davantage de risques – soit à emprunter et à prêter alors que les demandeurs de crédit ne sont plus capables que de payer les intérêts et de financer le principal en réempruntant. C’est le stade de la “finance spéculative” (Speculative Finance) où l’aveuglement se fonde sur le fait que la peur de manquer l’occasion de faire des profits – et plus encore de laisser à d’autres la chance d’engranger les bénéfices de sa propre pusillanimité – excède celle de se retrouver en situation de défaut de paiement.

Cette phase d’agitation des “esprits animaux”, pour reprendre l’expression de Keynes, culmine avec ce que Minsky qualifie de “finance de Ponzi” (Ponzi Finance), du nom du célèbre escroc Carlo Ponzi, qui offrait des rendements exceptionnels à ses clients les plus anciens en puisant dans les fonds amenés par les plus récents. À ce stade, le renchérissement des actifs financiers se poursuit encore mais ne se fonde plus sur l’accumulation des revenus de la production. Autrement dit, les emprunteurs ne peuvent plus rien rembourser, ni le principal ni les intérêts, mais continuent néanmoins à chercher des fonds.

Dès lors apparaissent les premiers signes d’un retournement de tendance : à court de liquidités, certains détenteurs de titres sont contraints de vendre ceux qu’ils ont en leur possession. Leur soudain changement d’attitude ne manque pas d’alerter leurs collègues et clients, qui ne tardent pas à leur emboîter le pas. À mesure que la quête de liquidités se répand, la panique succède à l’exubérance. Non moins procyclique que le sentiment de confiance, la peur des faillites fait qu’il n’y a rapidement plus d’acheteurs pour les titres dépréciés. Aussi le krach et ses conséquences, récessives voire dépressives, deviennent-ils inévitables.

Si Minsky n’est évidemment pas le seul économiste à s’être penché sur les mécanismes menant aux crises financières, il se distingue de ses prédécesseurs, Keynes excepté, en faisant de l’enchaînement des trois stades – finance couverte, finance spéculative, finance de Ponzi – un processus inhérent au capitalisme et dont le caractère explosif s’accentue avec son développement. Il revient en effet à l’augmentation de la productivité et à l’allongement des périodes de croissance de nourrir le déni de l’instabilité structurelle du mode de production capitaliste – déni dont la théorie néoclassique est l’expression parmi les économistes – et par conséquent d’aggraver considérablement l’incidence du “paradoxe de la tranquillité” sur la vie du plus grand nombre.

Parce qu’à ses yeux, il n’existe aucune force de rappel susceptible de rétablir l’équilibre, ou même de tempérer la nature “bipolaire” du capitalisme, Minsky gage la stabilisation d’une économie instable sur l’intervention des pouvoirs publics. Seuls les gouvernements élus, soutenait déjà Keynes, ont quelque raison de se préoccuper du long terme et de l’incidence du creusement des inégalités sur la prospérité des nations dont ils ont la charge. L’auteur de John Maynard Keynes abonde évidemment dans le sens de son maître à penser mais la manière dont il envisage l’action publique va quelque peu évoluer entre son premier et son second livre.

Plus radical jusqu’au tournant néolibéral des années 1980, Minsky n’est alors pas loin de considérer que la seule manière de stabiliser le capitalisme est d’en sortir – certes progressivement. Il rejoint sur ce point Joan Robinson – qu’il rencontre lors d’une année passée à Cambridge. Sceptique quant à l’efficacité de la redistribution fiscale et très critique vis-à-vis de la “guerre contre la pauvreté” de l’administration Johnson – qu’il voit comme une manière charitable de maintenir le statu quo – c’est la question de l’emploi qui lui paraît être l’enjeu décisif. Fidèle à un keynésianisme qui fait du plein emploi, plutôt que de la croissance, l’objectif de la politique macroéconomique, Minsky estime qu’il revient à l’État de se constituer en employeur de dernier ressort et à la banque centrale de configurer son rôle en conséquence. La croissance du secteur public et ce que les milieux patronaux appellent la “répression financière” sont à ses yeux les seuls moyens de contenir la propension du capitalisme à la spéculation.

Le succès de la contre-révolution néolibérale, et davantage encore l’effondrement de l’empire soviétique, vont toutefois modifier, sinon les analyses de Minsky, du moins les remèdes qu’il juge adéquats à un contexte où, comme l’énonce la célèbre formule, il est plus difficile d’imaginer la fin du capitalisme que celle du monde. Déjà dans Stabiliser une économie instable, et davantage encore dans ses textes ultérieurs, l’économiste va moins miser sur la multiplication des emplois publics que sur la déconcentration du secteur privé. La tâche principale qu’il assigne aux régulateurs et aux banquiers centraux consiste désormais à assurer la viabilité des petites et moyennes entreprises en favorisant la création d’une myriade de petites banques soucieuses de contribuer au développement local et régional. Autrement dit, pour le dernier Minsky, et au grand dam des tenants d’une synthèse marxo-keynésienne, “stabiliser une économie instable” cesse d’être une proposition teintée d’ironie.

1 https://www.bard.edu/library/a...

2 Hyman Minsky, John Maynard Keynes, (New York, Columbia University Press), 1975

3 Hyman Minsky, Stabilizing an Unstable Economy, (New York, McGraw-Hill), 2008; traduction française: Stabiliser un économie instable, préface d’André Orléan, postface de Michel Aglietta (Paris, Les petits matins/institute Veblen), 2016.

Lee Raymond

Lee R. Raymond (1983) prend la tête d’Exxon, puis ExxonMobil, de 1993 à 2025. Il supervise l’entreprise pendant une période décisive du débat mondial sur le climat. Bien que les scientifiques d’Exxon confirment, dès le début des années 1980, que la combustion d’énergies fossiles entraîne un réchauffement climatique considérable, Raymond remet publiquement en question ces conclusions dès qu'il devient PDG. Des rapports internes datant de 1982 mettent déjà en garde contre des changements climatiques majeurs, mais sous la direction de Raymond, ExxonMobil adopte une position nettement sceptique à l’égard du changement climatique d’origine anthropique.

Tout au long des années 1990, Raymond se positionne comme l’un des opposants les plus virulents à la politique climatique de l’époque. Lors du Congrès mondial du pétrole de 1997 à Pékin, juste avant les négociations du protocole de Kyoto, il déclare que les “les arguments en faveur du soi-disant réchauffement climatique sont loin d'être irréfutables”, affirmant que la variabilité naturelle expliquerait les changements de température observés et que la réduction des émissions irait à l’encontre du "bon sens". En tant que président de l’American Petroleum Institute, il diffuse des messages qui insistent sur l’incertitude scientifique. Sous sa direction, Exxon finance des groupes de réflexion et des organisations de défense, dépensant notamment près de 20 millions de dollars entre 1997 et 2005 pour promouvoir le scepticisme climatique et retarder toute action politique.

Dans une interview accordée à Charlie Rose en 2005, Raymond réitère ses arguments concernant le réchauffement climatique: le climat de la planète a toujours connu des variations naturelles, la science ne démontre pas une interférence humaine, et le consensus n’équivaut pas à la vérité. Il compare même la croyance au réchauffement climatique au moment où “90 % des gens pensaient que la Terre était plate”. Il soutient qu’agir sur la base d’une science incomplète nuira à l’économie et qu’il reste “du temps pour mieux comprendre le problème”.

Sous la direction de Raymond, ExxonMobil devient emblématique de l’obstruction des entreprises à l’action climatique. Alors que des concurrents comme BP commencent à reconnaître les risques climatiques à la fin des années 1990, Exxon redouble de scepticisme. Après le départ à la retraite de Raymond, la Royal Society et d’autres organisations condamnent les communications trompeuses d’ExxonMobil, et en 2008, l’entreprise met discrètement fin au financement de certains groupes climatosceptiques.

Aujourd’hui, les historiens considèrent Raymond comme l’une des figures ayant le plus façonné le discours climatique de la fin du XXᵉ siècle. Sous sa direction, l’opposition de l’industrie aux politiques de réduction des émissions se renforce, amplifiant les doutes du public et contribuant à retarder l’action mondiale pendant une décennie ou plus. L’“ère Raymond” devient un exemple édifiant de la manière dont la stratégie d’entreprise et la rhétorique persuasive peuvent entraver le consensus scientifique et freiner les progrès politiques.

William A. Nordhaus

Selon l’économiste français Antonin Pottier, la trajectoire intellectuelle de William Nordhaus commence de manière paradoxale avec sa critique du rapport The Limits to Growth du Club de Rome, publié en 1972. Ce rapport mettait en cause la durabilité de la croissance économique en affirmant que l’épuisement des ressources et la pollution finiraient par contraindre le développement mondial. À cette époque, Nordhaus était un jeune professeur à l’université de Yale et déjà un partisan affirmé de l’économie dominante. Il examina le rapport de manière critique et insista sur son absence de fondement empirique solide. Parmi les nombreux facteurs présentés comme susceptibles de provoquer un effondrement, Nordhaus identifia le changement climatique comme le seul capable d’engendrer de graves conséquences macroéconomiques au cours du siècle à venir.

À partir de 1974, Nordhaus se consacre plus directement à l’économie du changement climatique. Sa première contribution quantitative date de 1977, lorsqu’il propose une analyse coût-efficacité. À l’aide d’un modèle énergétique et d’un modèle du cycle du carbone, il estime les coûts associés à différents objectifs de stabilisation du CO₂ atmosphérique. En l’absence de référence établie, il définissait lui-même ces objectifs et considérait qu’un doublement de la concentration de CO₂, soit environ 550 parties par million, constituait une limite supérieure qu’il serait prudent de ne pas franchir.

Nordhaus se montre cependant insatisfait de ce qu’il juge être une méthode trop arbitraire. À ses yeux, les objectifs climatiques ne doivent pas reposer sur des préférences subjectives ni sur des principes moraux, mais être définis de manière "scientifique", c’est-à-dire par le calcul lui-même. Cette conviction le conduit, au cours des années 1980, à abandonner l’analyse coût-efficacité pour l’analyse coût-bénéfice. Il s’agit cette fois d’identifier le niveau optimal de réduction des émissions en évaluant l’équilibre entre les coûts de l’atténuation et les dommages évités.

Ce nouveau cadre intellectuel le mène à élaborer le modèle DICE (Dynamic Integrated Model of Climate and the Economy), finalisé au début des années 1990. DICE devient rapidement le modèle d’évaluation intégré de référence en économie du climat. Conçu comme une extension simplifiée du modèle néoclassique de croissance optimale, il interprète la réduction des émissions comme un investissement destiné à améliorer le bien-être futur et soumis à la même logique de rendement que les autres investissements productifs. L’objectif est de déterminer la trajectoire d’investissement optimale, ce qui revient à calculer un "niveau optimal de réchauffement" que devrait accepter un agent rationnel.

Du fait de l’influence centrale de Nordhaus dans la discipline et de la simplicité du modèle, directement inspiré des cadres de croissance standard, DICE se répand rapidement et devient l’outil analytique dominant en matière de politique climatique chez les économistes. En inscrivant l’évaluation du climat dans une optimisation intertemporelle de la consommation, Nordhaus place l’économiste au cœur du problème climatique. Il en fait l’arbitre des transferts de richesse entre générations et le juge chargé de concilier deux impératifs : minimiser les coûts économiques et limiter le réchauffement global.

Comme l’ont montré Naomi Oreskes et Erik M. Conway, l’héritage de Nordhaus s’inscrit aussi dans l’histoire du retard organisé de l’action climatique. Nordhaus cosigne notamment, avec Jesse Ausubel et Gary Yohe, le premier chapitre du troisième rapport de l’Académie nationale des sciences publié en 1983 sous la direction de William Nierenberg. Leur contribution, consacrée à l’usage de l’énergie et aux émissions de CO₂, reconnaît d’emblée qu’il existe "un large accord selon lequel les émissions de dioxyde de carbone d’origine anthropique augmentent régulièrement, principalement du fait de la combustion des combustibles fossiles". Leur attention se porte toutefois moins sur ce que l’on sait que sur ce que l’on ignore : l’"immense incertitude au-delà de l’an 2000" et l’"incertitude plus grande encore" concernant les effets sociaux et économiques des trajectoires possibles de CO₂.

À l’aide d’analyses probabilistes, ils projettent les concentrations atmosphériques jusqu’en 2100 selon différents scénarios d’usage de l’énergie, de coût et d’efficacité économique. Les résultats couvrent un éventail très large, mais ils estiment le scénario le plus probable à un doublement du CO₂ vers 2065. Ils admettent cependant qu’il existe une probabilité non négligeable d’un doublement avant 2050 et reconnaissent qu’il serait imprudent d’écarter cette possibilité. Pourtant, comme le soulignent Oreskes et Conway, ils tendent en pratique à la minimiser.

Que faire pour enrayer le changement climatique ? Pour Nordhaus, assez peu de choses. Selon lui, "la mesure la plus efficace serait d’imposer une taxe carbone permanente élevée", mais une telle mesure serait difficile à instaurer et à faire respecter. Il estime par ailleurs que des politiques strictes de réduction du CO₂ exigeraient des choix très contraignants, tandis que les stratégies évoquées par Schelling dans le même rapport, fondées sur l’adaptation ou la modification du climat, paraissent plus économiques. Il conclut qu’on ignore si les effets secondaires sur les sociétés seront plus coûteux qu’une réduction rigoureuse des gaz à effet de serre.

La contribution de Nordhaus au rapport de 1983 incarne ainsi une tendance majeure des politiques climatiques américaines : reconnaître le consensus scientifique tout en soulignant l’incertitude, préconiser le report de l’action et présenter l’adaptation ou l’innovation technologique comme des réponses préférables à l’atténuation immédiate.

Dans cette perspective, l’historien Jean-Baptiste Fressoz replace Nordhaus dans une histoire plus large de l’optimisme économique moderniste qui associe l’économie de l’innovation à l’imaginaire technopolitique de l’ère atomique. Dans Sans transition (2024), Fressoz décrit Nordhaus comme "l’un des futurologues atomistes des années 1970", dont la confiance dans le progrès technologique, notamment dans l’énergie nucléaire et les réacteurs surgénérateurs, soutient l’idée même de transition énergétique. Dans un article publié en 1973, Nordhaus soutient même que les efforts de sobriété énergétique risquent d’être excessifs, car "le progrès technologique résoudra bientôt la crise énergétique". Il prédit qu’à la fin du XXIe siècle, l’économie mondiale fonctionnera à l’hydrogène et à l’électricité issus de ressources illimitées, ce qu’il appelle le "stade final de la transition ». Le réacteur surgénérateur constitue pour lui une « technologie ultime", une sorte de filet de sécurité technologique que l’on retrouve ensuite dans ses modèles climatiques.

Pendant son séjour à l’International Institute for Applied Systems Analysis entre 1974 et 1975, Nordhaus rencontre l’ingénieur italien Cesare Marchetti qui l’initie à la modélisation du climat. Ensemble, ils imaginent un monde doté de ressources énergétiques inépuisables et de possibilités de géo-ingénierie. Nordhaus élabore alors un modèle mathématique simple visant à maximiser le PIB mondial tout en évitant un doublement du CO₂ et conclut que l’humanité dispose d’un "temps confortable" pour agir. Comme le remarque Fressoz, "la trajectoire optimale ne se distinguait guère de la trajectoire non régulée", résultat qui deviendra central dans son raisonnement ultérieur.

Fressoz souligne aussi que l’influence de Nordhaus dépasse largement le champ académique. Exxon s’appuie directement sur son idée selon laquelle il existe « assez de temps » pour organiser une transition ordonnée, afin de justifier la poursuite de l’exploitation fossile. Dans les années 1990, le modèle DICE s’impose au sein du Groupe de travail III du GIEC et institutionnalise une logique de procrastination. L’objectif de DICE est en effet de calculer la température optimale de la Terre que Nordhaus estime à trois degrés et demi, une valeur qu’il juge compatible avec la prospérité d’une "espèce technologique et nomade" qu’il nomme Homo adaptus.

Pour Fressoz, Nordhaus représente ainsi l’aboutissement d’une confiance moderniste dans l’innovation et les mécanismes de marché, confiance qui a sous-estimé les contraintes matérielles et l’inertie des systèmes énergétiques. En assimilant technologie et innovation, Nordhaus et ses héritiers ont entretenu l’idée que croissance économique et décarbonation peuvent progresser de concert. Une telle vision, écrit Fressoz, "a fourni les outils intellectuels de la procrastination", en légitimant le retard politique tout en introduisant dans les scénarios climatiques des options technologiques parfois fantaisistes comme la géo-ingénierie.

Sources :

Antonin Pottier, Comment les économistes réchauffent la planète, Seuil, 2016.

Naomi Oreskes et Erik M. Conway, Merchants of Doubt, Bloomsbury Press, 2010.

Jean-Baptiste Fressoz, Sans transition, Seuil, 2024.

Thomas C. Schelling

Thomas C. Schelling fut un économiste et stratège de premier plan, connu pour ses contributions à la théorie des jeux et à l’analyse économique du conflit et de la coopération. Figure centrale de la rationalité stratégique de la guerre froide, il participa de manière décisive à l’élaboration de la doctrine de la dissuasion nucléaire grâce à The Strategy of Conflict, publié en 1960, où il décrivait la négociation comme un processus visant à obtenir un avantage par la menace plutôt que par l’usage direct de la force. Il développa également la notion de "point focal", cet équilibre tacite auquel deux adversaires se rallient pour éviter une destruction mutuelle.

À la fin des années 1970 et au début des années 1980, Schelling transpose cette logique stratégique à la question émergente du changement climatique d’origine anthropique. Il préside l’étude que l’Académie nationale des sciences consacre en 1980 aux dimensions sociales et politiques du réchauffement, puis siège au Comité d’évaluation du dioxyde de carbone qui publie en 1983 le rapport Changing Climate sous la supervision de William A. Nierenberg. Contrairement aux usages de l’Académie, ce rapport ne fut pas signé collectivement, car il résultait en réalité de deux analyses distinctes. Les cinq chapitres rédigés par des scientifiques examinaient la probabilité d’un changement climatique causé par l’homme, tandis que deux chapitres consacrés aux émissions et aux impacts relevaient d’économistes comme William Nordhaus et Thomas Schelling.

Ce nouveau rapport répondait largement à ce que Naomi Oreskes et Erik Conway décrivent comme "l’année décisive du climat", 1979. Cette année-là, le météorologue Jule Charney, l’un des fondateurs de la modélisation numérique moderne de l’atmosphère, réunit huit scientifiques dans le centre d’étude estivale de l’Académie à Woods Hole, dans le Massachusetts. Il invita Syukuro Manabe et James E. Hansen à présenter les résultats de leurs modèles tridimensionnels les plus récents. La question centrale portait sur la sensibilité du climat, c’est-à-dire sur l’élévation moyenne de température attendue en cas de doublement du CO₂. La meilleure estimation disponible était d’environ trois degrés Celsius, avec une marge d’erreur de un degré et demi. Le rapport Charney concluait que la poursuite de l’augmentation du CO₂ provoquerait à coup sûr des changements climatiques et qu’il n’existait aucune raison de penser que ces changements seraient négligeables.

Dans la préface, Verner E. Suomi, président du Climate Research Board de l’Académie, insistait sur un point essentiel. L’océan, "immense volant d’inertie du système climatique", ralentirait la manifestation visible du changement, si bien qu’une politique d’attentisme risquait de conduire à réagir trop tard. Il soulignait que cette conclusion serait sans doute difficile à accepter pour les responsables politiques.

Cette prévision se vérifia. Avant même la publication du rapport Charney, la Maison-Blanche demanda des informations supplémentaires à l’Académie. La seconde étude, envoyée sous forme de lettre en avril 1980, fut présidée par Schelling. Elle avançait que les incertitudes scientifiques et économiques entourant le réchauffement justifiaient une suspension de toute mesure immédiate et un investissement accru dans la recherche. Schelling considérait qu’il n’était pas établi que les effets du réchauffement seraient majoritairement négatifs. Il estimait plausible que le climat du siècle suivant diverge fortement de celui du présent, mais jugeait tout aussi possible que les changements demeurent modérés et non nécessairement défavorables.

Pour Schelling, le réchauffement ne créerait pas des climats inédits. Il déplacerait les zones climatiques existantes, ce qui annonçait un argument récurrent du scepticisme : plutôt que de limiter l’usage des combustibles fossiles, l’humanité pourrait migrer et s’adapter. Il rappelait que la colonisation du Nouveau Monde avait déjà confronté de nombreuses populations à des environnements climatiques très différents, et en concluait que l’adaptation constituait la meilleure réponse, malgré la différence évidente entre le monde précolonial et celui des États modernes aux frontières rigides.

Il avançait également que l’horizon temporel du réchauffement laisserait suffisamment de temps pour se préparer. Selon lui, la hausse progressive du prix des combustibles fossiles réduirait d’elle-même leur consommation. Cette diminution permettrait à ses yeux d’atténuer le réchauffement, d’encourager les puits de carbone non atmosphériques et de faciliter la transition vers des énergies alternatives. Il pensait que ce processus suivrait spontanément les lois du marché, ce qui rendait toute régulation inutile.

Compte tenu des incertitudes qu’il soulignait, cette confiance dans les mécanismes spontanés du marché était remarquable. La consommation de combustibles fossiles a pourtant largement augmenté durant les décennies suivantes. Si sa prévision s’était révélée juste, aucune action réglementaire n’aurait été nécessaire. Le comité ne recommanda donc aucune réduction des émissions, tout en reconnaissant que « plus la transition serait amorcée tôt, plus elle serait aisée ». Il conclut cependant que la priorité devait aller à la recherche, menée « avec le profil politique le plus bas possible », dans l’idée que la science progresserait plus vite que le problème.

Le météorologue John Perry répondit à cette position dans Climatic Change par un article intitulé "Energy and Climate: Today’s Problem, Not Tomorrow’s", où il soutenait que le report des décisions constituait un risque en soi.

La troisième évaluation de l’Académie fut le rapport Changing Climate publié en 1983. Les chapitres rédigés par les scientifiques soulignaient la gravité des impacts d’un réchauffement non maîtrisé, tout en appelant à affiner les connaissances. Les chapitres rédigés par les économistes, ainsi que la synthèse, adoptaient en revanche une approche prudente et attentiste. Le premier chapitre, écrit par William Nordhaus, Jesse Ausubel et Gary Yohe, reconnaissait la progression continue des émissions de CO₂ d’origine humaine et leur lien avec la combustion des combustibles fossiles. Il insistait néanmoins sur l’ampleur des incertitudes au-delà de l’an 2000, en particulier quant aux effets sociaux et économiques. Les auteurs estimèrent que les changements majeurs pouvaient être renvoyés à l’avenir et recommandèrent l’introduction d’une taxe carbone permanente.

Dans son propre chapitre, Schelling développa une logique de "décote climatique". Il considérait que les effets du réchauffement appartenaient à un horizon trop éloigné pour les décideurs actuels. Il jugeait aussi qu’il serait abusif de traiter les émissions de CO₂ isolément, puisque la poussière atmosphérique, les changements d’usage des sols ou les variations naturelles contribuaient également aux dynamiques climatiques. Selon lui, il n’était pas évident que la solution doive nécessairement se situer du côté de la cause principale.

La synthèse rédigée par Nierenberg reprit ces arguments. Elle affirmait que les problèmes globaux de pollution et de dégradation environnementale rendaient la question du CO₂ difficile à traiter. Elle ajoutait cependant qu’en envisageant les effets du réchauffement à une échelle locale, il devenait possible d’y répondre comme à d’autres stress environnementaux par l’adaptation. La montée du niveau des mers pourrait rendre certaines régions inhabitables, mais l’histoire humaine, disait-il, montrait la grande capacité des sociétés à se déplacer et à reconstituer leurs structures sociales et matérielles.

Ce rapport convenait parfaitement aux attentes de la Maison-Blanche. Il minimisait les désaccords scientifiques, suggérait un consensus entre scientifiques et économistes et affirmait que l’innovation technologique réglerait les problèmes futurs. Il concluait qu’aucune action réglementaire immédiate n’était nécessaire, à l’exception du financement de la recherche.

La Maison-Blanche s’en servit pour affaiblir les premières évaluations climatiques de l’EPA. L’agence avait publié deux rapports qui décrivaient le réchauffement comme une menace sérieuse et recommandaient une réduction rapide de la consommation de charbon. Le conseiller scientifique du président, George Keyworth, invoqua les conclusions du comité Nierenberg pour discréditer les évaluations de l’EPA et affirma que la presse avait rejeté "l’alarmisme de l’EPA" au profit de la "position prudente de l’Académie".

La lecture que le philosophe Pierre Charbonnier propose de Schelling diffère en partie de celle de Naomi Oreskes et Erik Conway. Pour ces derniers, Schelling appartient à la constellation d’experts qui ont fourni un cadre intellectuel permettant de retarder l’action climatique en mobilisant l’incertitude et l’intérêt national. Charbonnier ne conteste pas ce constat mais estime qu’il ne suffit pas à expliquer son influence. Schelling réussit surtout à traduire le changement climatique dans le langage du pouvoir, de la sécurité et de la négociation stratégique, un langage déjà familier aux élites étatiques. Autrement dit, même en l’absence de lobbying fossile, son approche aurait trouvé un écho parmi les gouvernants.

Charbonnier reconstruit son paradigme climatique autour de trois principes. Le risque est d’abord subordonné aux capacités d’adaptation : le réchauffement est réel mais évolue plus lentement que le progrès technologique et reste donc gérable, notamment grâce à l’innovation future, même s’il accentuera les inégalités mondiales. Ensuite, il estime que des accords climatiques universels et contraignants sont structurellement improbables, car le climat est inséparable de la sécurité énergétique et des rivalités géopolitiques, et les États ne sont pas disposés à sacrifier leur souveraineté pour un risque considéré comme secondaire. Enfin, la politique climatique devient une négociation permanente, analogue aux discussions sur le contrôle des armements, qui vise à déterminer un niveau « optimal » de réchauffement. Ce niveau correspond au point focal climatique de Schelling, au-delà duquel les émissions cessent d’être économiquement profitables pour devenir stratégiquement dangereuses.

Pour décrire cette combinaison de pensée de la dissuasion, de calcul coûts–avantages et de développement fossile, Charbonnier parle d’une "écologie Strangelove". Cette écologie ne remet pas en cause les prémisses stratégiques de l’État de la guerre froide. Elle s’en sert pour rendre le climat gouvernable. Sa force réside dans la capacité à offrir aux décideurs une synthèse géoéconomique immédiatement disponible, que la plupart des écologies normatives n’ont jamais su produire.

Sources : Naomi Oreskes et Erik M. Conway, Merchants of Doubt, Bloomsbury Press, 2010, chap. 6; Pierre Charbonnier, Vers l’écologie de guerre, La Découverte, 2024, chap. 5.

Roger Revelle

Roger Revelle fut un océanographe et un spécialiste du climat de tout premier plan. Il joua un rôle décisif dans l’histoire de la recherche climatique et exerça une influence durable comme enseignant, notamment sur Al Gore, qui suivit ses cours à Harvard dans les années 1960.

L’intérêt de Revelle pour le changement climatique mondial s’affermit à la fin des années 1950 lorsqu’il cosigna avec Hans E. Suess l’article fondateur intitulé "Carbon Dioxide Exchange Between Atmosphere and Ocean and the Question of an Increase of Atmospheric CO₂ During the Past Decades". Cette étude montrait que les océans ne pouvaient absorber l’ensemble du dioxyde de carbone d’origine anthropique. Elle indiquait ainsi que la concentration atmosphérique de CO₂ augmenterait de manière inévitable du fait de la combustion des combustibles fossiles. Peu après, Revelle obtint des financements pour permettre à son collègue, le chimiste Charles David Keeling, d’effectuer des mesures systématiques de la concentration atmosphérique en CO₂. Ces travaux produisirent la célèbre courbe de Keeling, qui met en évidence la progression continue du CO₂ dans l’atmosphère. Keeling reçut plus tard la National Medal of Science et fut largement popularisé par Al Gore dans An Inconvenient Truth.

En 1965, le President’s Science Advisory Committee demanda à Revelle, alors directeur de la Scripps Institution of Oceanography, de rédiger une synthèse sur les effets possibles d’un réchauffement provoqué par le dioxyde de carbone. Conscient des incertitudes persistantes, il choisit de se concentrer sur l’impact qu’il jugeait le plus certain : l’élévation du niveau de la mer. Il formula également une prévision remarquable pour l’époque : "D’ici l’an 2000, l’atmosphère pourrait contenir environ vingt-cinq pour cent de CO₂ en plus qu’aujourd’hui, et cette augmentation modifiera le bilan thermique de l’atmosphère au point que des changements marqués du climat pourraient se produire".

Deux décennies plus tard, Revelle contribua à Changing Climate: Report of the Carbon Dioxide Assessment Committeepublié en 1983, une étude dirigée par William A. Nierenberg. Il y avertissait à nouveau que la désintégration de la calotte glaciaire de l’Antarctique occidental pourrait entraîner une élévation du niveau des mers de cinq à six mètres. Selon lui, un tel scénario aurait pour effet d’inonder les ports existants, les zones côtières basses, de vastes régions agricoles situées dans les deltas densément peuplés, ainsi que des portions importantes de la Floride, de la Louisiane et de nombreuses grandes métropoles. Sur le plan des politiques publiques, Revelle recommandait une transition progressive vers le gaz naturel et l’énergie nucléaire, accompagnée d’une réduction de l’usage du charbon et du pétrole. Il insistait aussi sur la nécessité de soutenir la recherche scientifique et mettait en garde contre la tentation de surestimer les incertitudes.

Revelle se retrouva au centre d’une controverse au début des années 1990 lorsque quelques scientifiques affirmèrent qu’il avait changé de position sur le réchauffement climatique. Cette affirmation provenait d’un article cosigné avec S. Fred Singer et Chauncey Starr, intitulé "What to Do About Greenhouse Warming: Look Before You Leap", publié en 1991 dans Cosmos: A Journal of Engineering and Science, revue du très sélectif Cosmos Club de Washington. Revelle y apparaissait comme deuxième auteur et semblait soutenir l’idée que le réchauffement attendu au cours du siècle serait probablement modéré, inférieur à un degré Celsius.

Cet article provoqua pourtant la gêne de Revelle. Cosmos n’était pas une revue scientifique évaluée par les pairs, et plusieurs collègues rapportèrent qu’il qualifiait le texte en privé de « foutaise ». L’océanographe Walter Munk souligna qu’il était connu pour son incapacité à refuser une demande et suggéra qu’il n’avait peut-être jamais donné son accord explicite pour figurer comme coauteur. Christa Beran, sa secrétaire de longue date, affirma plus tard dans un témoignage écrit que Revelle lui avait confié : "Certains pensent que Fred Singer n’est pas un très bon scientifique".

Cet épisode se déroula alors que Revelle vivait les derniers mois de sa vie et lui causa une tension considérable. En février 1991, il fut victime d’une grave crise cardiaque en rentrant à La Jolla après une conférence. Il dut subir un pontage coronarien triple, qui fut suivi de complications et d’infections. Son état se dégrada rapidement, au point de ne plus pouvoir assurer une correspondance régulière ou un encadrement scientifique. Il mourut d’une seconde crise cardiaque en juillet 1991. L’article de Cosmos fut ensuite instrumentalisé lors de la campagne présidentielle de 1992 pour affaiblir Al Gore, présenté à tort comme l’élève d’un Revelle prétendument revenu sur ses propres mises en garde concernant le changement climatique.

Source : Naomi Oreskes et Erik M. Conway, Merchants of Doubt: How a Handful of Scientists Obscured the Truth on Issues from Tobacco Smoke to Global Warming, New York, Bloomsbury Press, 2010.

Siegfried Fred Singer

Siegfried Fred Singer (1924–2020) fut un physicien et entrepreneur politique dont la carrière embrassa la recherche sur la haute atmosphère et la météorologie satellitaire avant de se tourner vers des interventions déterminantes dans les débats de politique environnementale. Comme l’ont montré Naomi Oreskes et Erik Conway dans Merchants of Doubt, son parcours illustre comment une autorité scientifique forgée durant la guerre froide put être reconvertie pour contester les politiques de régulation en exaltant l’incertitude, les coûts économiques et les vertus présumées du marché. Formé comme physicien pendant la Seconde Guerre mondiale, il se distingue dans les années 1950 par ses travaux menés à l’aide de fusées sondes sur les rayonnements cosmiques et le champ magnétique terrestre, et compte parmi les tout premiers promoteurs des satellites scientifiques. Il dirige ensuite le National Weather Satellite Center et occupe divers postes de conseil au sein des administrations Nixon et Reagan, s’installant durablement à l’interface entre institutions de recherche et appareils gouvernementaux.

Au tournant des années 1970, Singer apparaît d’abord comme un environnementaliste inspiré par les diagnostics éco-malthusiens. Lors d’un symposium de l’American Association for the Advancement of Science, il mobilise l’article influent de Garrett Hardin sur la "Tragédie des biens communs" et plaide en faveur d’une protection accrue de l’environnement. Dans un ouvrage consacré à la question démographique publié en 1971, il met en garde contre les risques d’une croissance incontrôlée et appelle à des mesures de précaution. La seconde moitié de la décennie marque cependant un tournant décisif. Un rapport rédigé pour la Mitre Corporation promeut l’analyse coûts–avantages comme outil central d’évaluation des politiques environnementales et insiste sur le poids financier de la lutte contre la pollution comparé à des bénéfices qu’il juge incertains. Au début des années 1980, Singer adopte une vision nettement plus optimiste en affirmant que l’innovation technologique, stimulée par la dérégulation, serait en mesure de dissiper d’elle-même les contraintes écologiques.

Cette inflexion idéologique devient manifeste lors de la controverse sur les pluies acides. En 1982 et 1983, l’administration Reagan décide de contourner l’Académie nationale des sciences et de commander sa propre expertise. William Nierenberg est alors nommé à la présidence du comité. À la demande de la Maison-Blanche, Singer est intégré au groupe. Il en est le seul membre sans affiliation universitaire permanente. Le rapport consensuel conclut que les émissions de dioxyde de soufre constituent la cause principale des dépôts acides et recommande des réductions immédiates. Singer refuse cette conclusion et rédige une annexe dissidente. Il y met en avant les incertitudes persistantes et souligne le coût des mesures de contrôle des émissions. Il préconise un essai limité et peu coûteux avant toute réduction substantielle. Cette position rejoint les arguments de l’industrie électrique et contribue à retarder la mise en œuvre des mesures envisagées. Le résumé exécutif du rapport est ensuite remanié en concertation avec l’Office of Science and Technology Policy, de manière à faire apparaître l’incertitude en premier lieu. Singer affirmera plus tard que ce report a permis d’économiser plusieurs milliards de dollars par an.

Dans les années suivantes, Singer étend sa contestation aux fondements scientifiques de l’appauvrissement de la couche d’ozone. Il soutient que le trou d’ozone observé au-dessus de l’Antarctique pourrait résulter du refroidissement stratosphérique et de la variabilité naturelle. Selon lui, les émissions de chlorofluorocarbures ne jouent qu’un rôle secondaire. Cette affirmation contredit pourtant les conclusions largement établies de la chimie atmosphérique. Singer met également en cause les rapports du Surgeon General et de l’Environmental Protection Agency qu’il accuse de poursuivre des objectifs avant tout politiques. Son étude hostile à l’EPA, financée de manière indirecte par le Tobacco Institute grâce à l’Alexis de Tocqueville Institution, confirme sa proximité croissante avec les intérêts industriels opposés à la régulation environnementale.

De la fin des années 1980 au cours des années 1990, Singer s’impose comme l’une des voix les plus influentes de la contestation publique des sciences du climat. Il affirme que les incertitudes scientifiques restent trop importantes pour justifier des politiques coûteuses. En 1991, il cosigne un article dans Cosmos avec Roger Revelle et Chauncey Starr intitulé "What to Do About Greenhouse Warming: Look Before You Leap"1. Des archives et témoignages montrent pourtant que Revelle, affaibli après une lourde intervention cardiaque, s’était montré réticent et n’avait participé à sa rédaction qu’à la marge. L’article suggère que le réchauffement restera modéré et difficile à distinguer de la variabilité naturelle. Cette thèse contredit les conclusions que Revelle et Hans Suess avaient établies dès 1957 dans leur étude fondatrice sur les échanges de dioxyde de carbone entre l’atmosphère et l’océan2. Lors de la campagne présidentielle de 1992, le texte de Cosmos est utilisé pour affaiblir Al Gore, ancien étudiant de Revelle. Lorsque Justin Lancaster, doctorant proche de Revelle, conteste publiquement la présentation défendue par Singer, celui-ci engage une action en diffamation. L’affaire se conclut par une ordonnance de silence et un accord amiable.

Au milieu des années 1990, les sciences du climat franchissent un seuil important avec les études de détection et d’attribution. Grâce aux techniques de fingerprinting, des chercheurs comme Benjamin Santer démontrent que les schémas observés de réchauffement correspondent aux signatures attendues d’un forçage par les gaz à effet de serre. Ces schémas ne peuvent être attribués à la seule variabilité naturelle. En 1995, Santer, Tom Wigley et plusieurs collègues rédigent le chapitre 8 du deuxième rapport d’évaluation du GIEC. Ils y concluent que l’ensemble des données disponibles indique une influence humaine discernable sur le climat. Cette conclusion suscite une réaction immédiate. Singer, Frederick Seitz et d’autres membres du réseau du Marshall Institute dénoncent publiquement le fonctionnement du GIEC dans Science et dans le Wall Street Journal. Ils accusent Santer d’avoir modifié son chapitre après son approbation et d’avoir minimisé les incertitudes. Ils affirment également qu’il aurait exclu des contributions dissidentes, notamment celle de Patrick Michaels. Ces accusations sont infondées, car les révisions suivaient les procédures officielles du GIEC. Les incertitudes figuraient clairement dans le texte final et Michaels avait été invité à participer, ce qu’il a décliné. Aussi infondée qu’elle soit, la campagne orchestrée par Singer et Seitz trouve un écho important dans les sphères politiques et médiatiques. Seitz évoque une "corruption du processus d’évaluation par les pairs" et Singer parle de "nettoyage scientifique". De nombreuses sociétés savantes et plusieurs climatologues de premier plan défendent pourtant Santer et le GIEC mais la polémique contribue à semer le doute à propos de la science climatique. Elle offre ainsi un argument supplémentaire à ceux qui souhaitent retarder l’action politique.

La trajectoire intellectuelle de Singer rejoint enfin la philosophie cornucopienne défendue par Julian Simon. L’idée que l’ingéniosité humaine permettrait d’accroître indéfiniment les ressources disponibles innerve une large part de ses prises de position. Dès 1970, il manifeste une nette irritation face à ce qu’il perçoit comme des discours alarmistes. Dans un éditorial publié dans Science, il soutient que la combustion des énergies fossiles ne produira pas de réchauffement notable, les aérosols atmosphériques étant, selon lui, susceptibles de compenser l’effet de serre. Il met alors en garde la communauté scientifique contre le risque de "crier au loup". Si les aérosols ont effectivement atténué une partie du réchauffement durant les premières décennies, Singer refuse d’admettre que l’accumulation continue de dioxyde de carbone finit nécessairement par dépasser cet effet transitoire.

Dans les années 1980, Singer admet encore que la vision cornucopienne qu’il défend suppose l’existence durable d’une énergie abondante et peu coûteuse, condition sans laquelle l’ingéniosité humaine ne suffirait pas à repousser les limites écologiques. Il abandonne pourtant rapidement cette réserve, et au cours des années 1990 il adopte pleinement l’optimisme technologique de Julian Simon. La publication en 1999 de Hot Talk, Cold Science: Global Warming’s Unfinished Debate, préfacé par Frederick Seitz et largement fondé sur cette perspective, en offre une illustration explicite. Sa participation au volume collectif dirigé par Simon, The State of Humanity, aux côtés de Patrick Michaels et Laurence Kulp, confirme encore son adhésion à cette orientation intellectuelle.

La trajectoire de Singer évolue ainsi progressivement d’un profil de physicien de la guerre froide vers celui d’un acteur central du déni organisé. Les compétences scientifiques qui avaient contribué à l’institutionnalisation de la météorologie satellitaire deviennent des instruments mobilisés dans des campagnes destinées à retarder la régulation des pluies acides, des substances destructrices de la couche d’ozone, de la fumée de tabac ou encore des gaz à effet de serre. Singer ne s’emploie que rarement à nier directement les phénomènes documentés par la recherche ; il préfère amplifier les incertitudes résiduelles, insister sur les coûts économiques associés à toute action publique et promouvoir des solutions fondées sur les mécanismes de marché. Aux côtés de Frederick Seitz, William Nierenberg et Robert Jastrow, il s’impose ainsi comme l’un des architectes majeurs du scepticisme climatique organisé.

1 Revelle, Roger, Chauncey Starr, and S. Fred Singer. “What to Do About Greenhouse Warming: Look Before You Leap.” Cosmos: A Journal of Engineering and Science 5, no. 2 (1991): 28–33.

2 Revelle, Roger, and Hans E. Suess. “Carbon Dioxide Exchange Between Atmosphere and Ocean and the Question of an Increase of Atmospheric CO₂ During the Past Decades.” Tellus 9, no. 1 (1957): 18–27.

Source : Naomi Oreskes et Erik M. Conway, Merchants of Doubt. How a Handful of Scientists Obscured the Truth on Issues from Tobacco Smoke to Global Warming, New York, Bloomsbury Press, 2010.

William A. Nierenberg

William Aaron Nierenberg (1919-2000) est un physicien de la génération de la guerre froide dont l’autorité scientifique et l’engagement politique font de lui une figure clé de la gestion des sciences environnementales sous l’administration Reagan. Formé à l’université de Columbia pendant le projet Manhattan, il dirige ensuite les laboratoires Hudson de Columbia avant de devenir, en 1965, directeur de l’Institut d’océanographie Scripps, où il consolide les liens étroits entre l’océanographie et la recherche financée par l’armée.

Dans les années 1970, Nierenberg s’impose à la fois comme un administrateur de premier plan et comme un conservateur au franc-parler. Il soutient la guerre du Vietnam, critique le mouvement étudiant et adopte une position combative à l’égard de l’environnementalisme, en particulier dans son opposition à l’énergie nucléaire. Ces positions font de lui un atout précieux pour le programme de Ronald Reagan. Il fait partie des équipes de transition de l’administration, est envisagé pour le poste de conseiller scientifique, rejoint le National Science Board et est consulté à plusieurs reprises sur des questions de défense et d'énergie.

Son rôle le plus marquant se manifeste lors de la controverse sur les pluies acides au début des années 1980. À cette époque, des recherches approfondies menées en Amérique du Nord et en Europe démontrent que les émissions de dioxyde de soufre provenant du charbon et du pétrole constituent la principale cause des précipitations acides. Les rapports de l’Académie nationale et de l’Agence de protection de l’environnement appellent à une réduction drastique des émissions. Confrontée à ces conclusions et à la perspective de réglementations coûteuses, l’administration Reagan commande une nouvelle étude à l’Office of Science and Technology Policy, qu’elle confie à Nierenberg.

Le "panel Nierenberg" confirme largement le consensus scientifique : les pluies acides sont réelles, anthropiques et nuisibles, et il recommande de réduire rapidement les émissions. Cependant, une fois rédigé, le rapport est modifié sous la pression politique. Sur l’insistance de la Maison Blanche, Fred Singer est ajouté au panel et rédige une annexe dissidente qui met l’accent sur l’incertitude et les coûts. Plus important encore, le résumé destiné aux décideurs est révisé en consultation avec la Maison Blanche : les termes forts appelant à une réduction rapide des émissions sont adoucis, l’incertitude est mise en avant et les progrès réalisés dans le cadre des lois existantes sont valorisés. Plusieurs membres du panel protestent contre ces modifications non autorisées, mais Nierenberg les laisse en l’état, offrant ainsi à l’administration un prétexte pour reporter toute action.

À court terme, son autorité permet à Reagan de bloquer les initiatives du Congrès, de faire stagner les négociations bilatérales avec le Canada et de retarder l’adoption d’une réglementation substantielle jusqu’aux amendements de 1990 à la Clean Air Act. À plus long terme, Nierenberg maintient et même accroît son influence grâce au George C. Marshall Institute. Cofondé en 1984 par lui-même, Robert Jastrow et Frederick Seitz, cet institut devient une plateforme centrale pour remettre en question la science du climat. La trajectoire de Nierenberg montre comment les physiciens de la guerre froide, façonnés par le complexe atomique et militaro-industriel, en viennent à mobiliser leur autorité non pas pour nier purement et simplement les sciences environnementales, mais pour amplifier l’incertitude et mettre en avant les coûts économiques afin de retarder la réglementation.

Fidèle à son idéologie et à ses méthodes, Bill Nierenberg devient également une figure clé des débats scientifiques et politiques autour du changement climatique lorsqu’il est nommé président du Comité d’évaluation du dioxyde de carbone (voir le portrait de Thomas Schelling dans le chapitre 4).

Source : Naomi Oreskes and Erik M. Conway, Merchants of Doubt: How a Handful of Scientists Obscured the Truth on Issues from Tobacco Smoke to Global Warming (New York: Bloomsbury Press, 2010).

Thierry Déau

Classé 233ème fortune professionnelle de France en 2025 par Challenges1, avec une fortune s’élevant à 600 millions d’euros, Thierry Déau est le fer de lance du derisking environnemental en France. Proche d’Emmanuel Macron – il a notamment largement financé sa première campagne présidentielle –, il a fondé en 2005 le fonds d’investissement Meridiam qui gère plus de 23 milliards d’euros d’actifs. Spécialisé en investissements durables dans les infrastructures, Meridiam se targue de respecter nombre de critères définis par les organisations internationales, comme les Principes d’investissement responsable des Nations Unies et les normes en matière environnementale, sociale et de gouvernance de la Banque Européenne d’Investissement, de la Banque Européenne pour la Reconstruction et le Développement et de la Société Financière Internationale. Aujourd’hui, Meridiam gère 130 projets dans le monde, allant d’un champ d’éoliennes en Égypte au Terminal B de l’aéroport LaGuardia à New York à en passant par cinq hôpitaux en Turquie. Sur son site web, le fonds d’investissement divise ses actifs en trois catégories : (1) “la mobilité durable” qui regroupe la construction de rails, de tramways et d’aéroports, (2) “les solutions innovantes bas-carbone” – Meridiam investit dans la production d’énergie renouvelable, la fourniture d’eau potable, et les points de recharge de véhicules électriques, (3) enfin, ironiquement, les mal-nommés “services publics essentiels” (des lits d’hôpitaux, établissements de santé et crèches).

Thierry Déau a été l’un des principaux instigateurs du derisking. Après avoir travaillé pendant dix ans à Egis Projects, une filiale de la Caisse des Dépôts spécialisée dans la gestion de projets à long terme, il a décidé de créer son propre fonds. Son idée était de mener des activités similaires à celles d’Egis, de l’investissement dans les infrastructures, mais en mobilisant des capitaux privés. Il rencontre d’abord de la résistance – comme il le raconte à une journaliste des Échos, “parce que la recherche de rentabilité en peu de temps n’est pas compatible avec des activités de service public2”. Le succès vient après la crise financière de 2008 : Thierry Déau l’attribue au fait que les investisseurs auraient placé leur confiance dans les infrastructures après l’échec des produits dérivés. Face au succès de Meridiam, il est choisi en tant qu’expert par la Commission européenne et la Banque européenne d’investissement pour mettre en œuvre le Plan Juncker, opération de derisking déployée par l’Union européenne pour relancer l’économie et améliorer les infrastructures européennes. Il a participé à la fondation du Partenariat d’Investissement pour le Développement Durable (Sustainable Development Investment Partnership), initiative de derisking co-fondée par l’OCDE et le Forum économique mondial en 2015.

Thierry Déau cherche à entretenir une image irréprochable de son activité et de lui-même. Engagé dans de nombreuses opérations philanthropiques, il est entre autres l’un des principaux mécènes de l’Opéra de Paris. Né à Fort-de-France dans une famille modeste, il a fondé avec sa fille la fondation Archery, qui accompagne des élèves de quartiers populaires dans leurs parcours scolaires et personnels et finance leurs études. En 2017, le projet de la Centrale Électrique de l’Ouest Guyanais, financé par Meridiam, se voit attribuer par l’Office national des forêts un terrain d’exploitation qui représentait jusque-là une forêt de chasse pour une population autochtone, sans que celle-ci ait été consultée. Après des années de confrontation, Thierry Déau a accepté de compenser financièrement le village kali’na par un accord consistant à lui verser 150 000 euros, puis 50 000 euros par an pendant les 25 ans d’exploitation du site3. Là où sa réputation est plus compromise, en revanche, c’est dans l’affaire de la fusion Veolia-Suez: Déau compte en effet parmi les soupçonnés de trafic d’influence par le Parquet national financier.

1 https://www.challenges.fr/classements/fortune/thierry-deau_26789

2 “Thierry Déau, le patron très engagé du fonds Meridiam”, Les Échos, Valérie de Senneville, 24 janvier 2023.

3 “En Guyane, le conflit autour d’une centrale électrique sur des terres amérindiennes se dénoue”, Le Monde, Laurent Marot, 31 octobre 2024.

Timelines

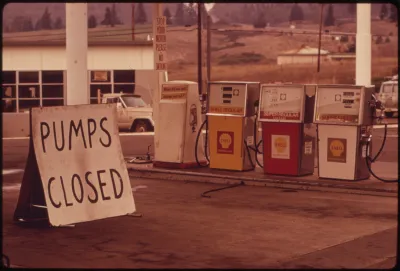

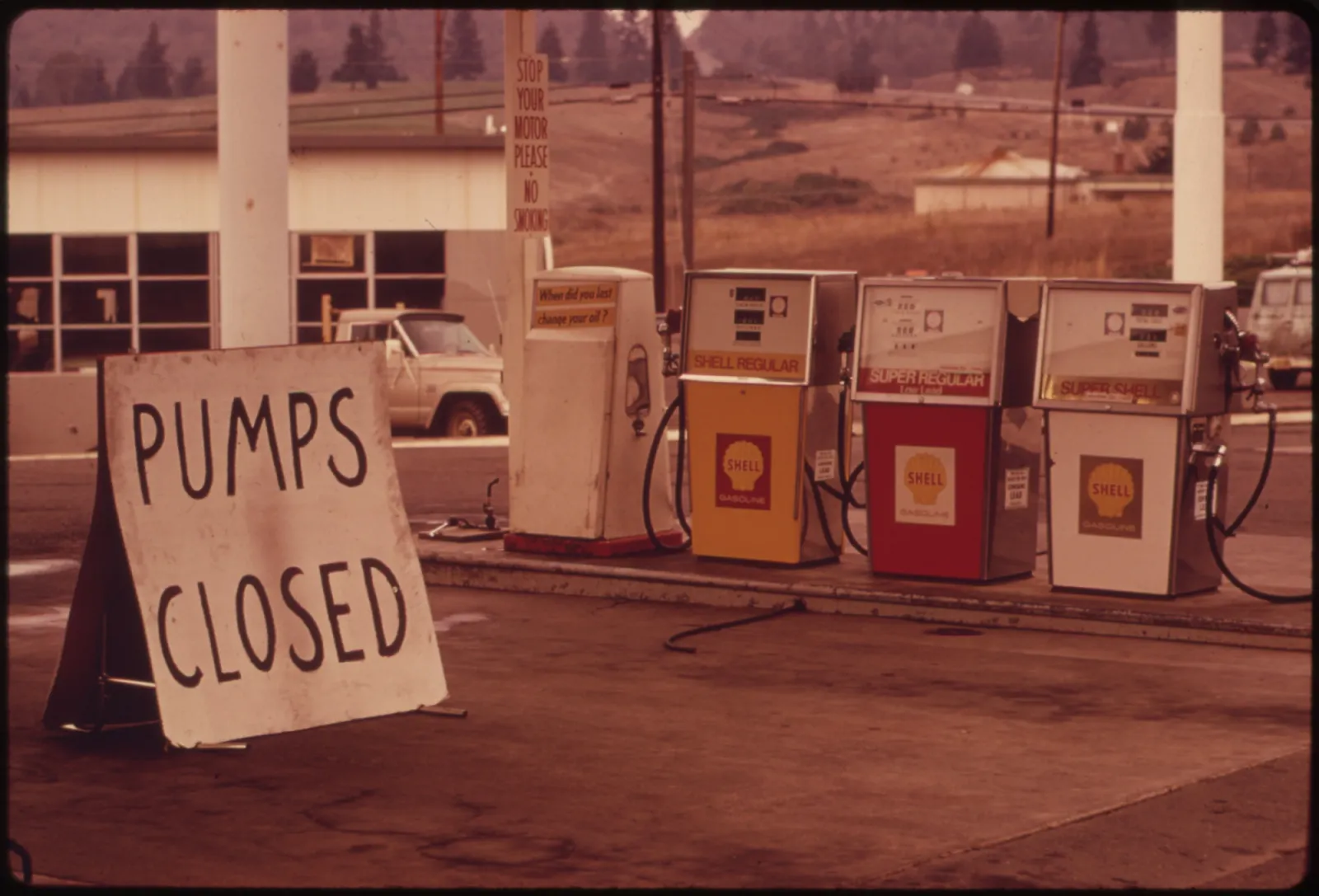

1973

L’OPEP et la première vague de sécurisation des ressources dans les années 1970. L’ascension de l’Organisation des pays exportateurs de pétrole (OPEP) dans les années 1970 marque un tournant majeur dans l’affirmation de la souveraineté des pays du Sud sur leurs ressources, remettant en cause la domination occidentale par la nationalisation des industries pétrolières. Le choc pétrolier de 1973, la nationalisation du cuivre au Chili en 1971, et les craintes croissantes de raréfaction des ressources conduisent les États-Unis à lancer des politiques de sécurité énergétique, telles que le « Project Independence » de Nixon ou les mesures de Carter. Ces stratégies reprennent des dispositifs hérités de la Seconde Guerre mondiale, notamment le stockage stratégique de minéraux comme le lithium. Les projets contemporains d’un « OPEP du lithium » font écho à cette première ruée vers les frontières extractives, fondatrice du capitalisme global.

2008

Le boom des matières premières : la sécurité des ressources à l’ère de la crise de 2008. Le boom des matières premières autour de 2008, porté par l’industrialisation rapide de la Chine, ravive les inquiétudes du Nord global face à sa dépendance aux ressources dans un contexte de crise financière. Tandis que les États-Unis subissent les conséquences du krach et que naissent des mouvements comme Occupy, les pays exportateurs de ressources profitent de la demande mondiale. Les terres rares — essentielles aux technologies vertes — deviennent un enjeu stratégique majeur, la Chine contrôlant plus de 70 % de la production. Bien que ces ressources ne soient pas géologiquement rares, leur extraction entraîne de lourds dégâts environnementaux et sanitaires, particulièrement en Chine, où l’absence de régulation conduit à une contamination massive des sols et à la prolifération de « villages du cancer ».

2018

La sécurité des ressources sous le premier mandat de Trump. En 2018, l’administration Trump élargit la définition des « minéraux critiques » et allège les régulations pour relancer l’extraction nationale, en particulier du lithium. Cette orientation, ancrée dans un nationalisme économique, associe politique minérale, sécurité nationale et relance industrielle. Des décrets exécutifs et des propositions législatives, comme l’American Mineral Act de la sénatrice Lisa Murkowski, présentent la dépendance vis-à-vis des importations chinoises comme une menace stratégique. Même des responsables comme Francis Fannon, alors secrétaire adjoint à l’Énergie, mettent en avant les enjeux éthiques et écologiques liés à l’extraction à l’étranger, plaidant pour un approvisionnement « allié » afin de garantir la crédibilité de la transition énergétique.

2021-2024

La politique industrielle de Biden pour une domination verte. L’administration Biden reprend et amplifie les politiques minières initiées sous Trump, en les réorientant vers les objectifs de transition écologique. Un rapport sur les chaînes d’approvisionnement publié en 2021 propose une stratégie de filière lithium intégrée — de l’extraction au recyclage — appuyée par la loi sur la production de défense et des financements publics massifs. La loi sur les infrastructures (2021), l’Inflation Reduction Act (IRA) et le CHIPS and Science Act (2022) allouent plusieurs centaines de milliards de dollars à la relocalisation industrielle, tout en imposant des règles strictes sur la provenance des composants pour véhicules électriques. En 2024, Biden augmente fortement les tarifs douaniers sur les batteries, véhicules électriques et minéraux chinois, associant transition énergétique et compétition géopolitique, au risque de brouiller la frontière entre action climatique et protectionnisme.

2025

Trump 2.0. Depuis son retour à la Maison-Blanche en janvier 2025, Trump a relancé une stratégie offensive en matière de minéraux critiques. Le décret 14241 invoque la loi sur la production de défense pour accélérer l’exploitation sur le sol américain. Le décret 14272 ordonne une enquête sur les risques liés aux importations de minéraux transformés, prélude à de potentielles sanctions commerciales. Un troisième décret promeut l’exploitation offshore des grands fonds marins. En mai 2025, dix nouveaux projets miniers sont intégrés au programme FAST-41 de simplification des procédures. Cette stratégie, qui vise l’autonomie minérale des États-Unis et leur domination sur les matériaux stratégiques, s’accompagne paradoxalement d’un désengagement des investissements renouvelables.

2015

L’agenda From Billions to Trillions. L’accès au capital privé pour financer des projets d’infrastructure et de service public devient une solution proposée par les institutions internationales, dans un contexte où les politiques d’austérité les amènent à considérer les financements publics comme “rares”. En juillet, la Banque mondiale publie l’agenda From Billions to Trillions, et en septembre les États membres des Nations Unies adoptent les Objectifs de Développement Durable (Sustainable Development Goals). L’agenda From Billions to Trillions est une initiative des banques multilatérales de développement (l’African Development Bank, l’Asian Development Bank, l’European Bank for Reconstruction and Development, l’European Investment Bank, l’Inter-American Development Bank Group et la Banque mondiale), ainsi que du Fonds Monétaire International. Elle vise à mettre en place les opérations de derisking nécessaires au financement des projets contenus dans les Objectifs de Développement Durable : effets de levier grâce à leurs fonds, conseil politique et réglementaire pour aider les pays à attirer des fonds de capitaux privés pour financer le développement durable. Dans l’Union européenne, les pays membres adoptent le plan d’investissement pour l’Europe. Aussi appelé « Plan Juncker », il vise à rattraper un retard d’investissement et accroître la compétitivité de l’Europe, en utilisant des fonds propres de l’UE et de la Banque européenne d’investissement pour mobiliser des financements publics et privés grâce à un effet de levier.

2017

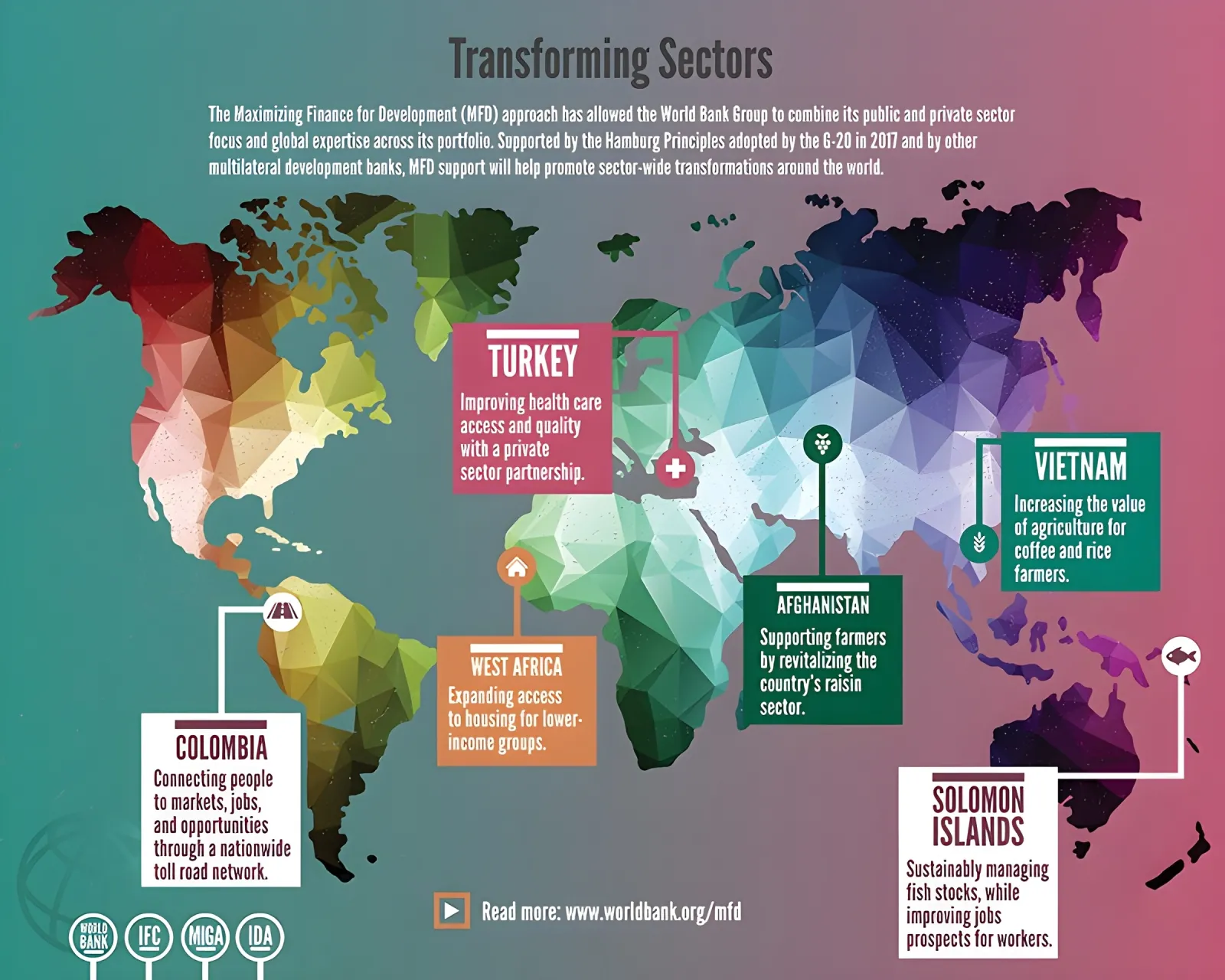

L’agenda Maximizing Finance for Development. L’agenda Maximizing Finance for Development de la Banque mondiale a pour objectif de promouvoir le recours au capital privé pour le financement de projets de développement visant à mettre fin à la pauvreté extrême tout en respectant les objectifs de développement durable. Il représente une intensification et une systématisation de l’agenda From Billions to Trillions, dans la suite des Principes de Hambourg adoptées par le G20 en 2017. Les trois principales priorités de l’agenda sont les suivantes : renforcer les capacités d’investissement et adapter les cadres réglementaires aux niveaux national et supranational, augmenter l’implication du secteur privé et prioriser les sources de financement commerciales, et augmenter le rôle catalytique des banques multilatérales de développement.

2020

La taxonomie européenne pour les activités durables. La taxonomie européenne pour les activités durables est adoptée en juillet. Elle définit les différentes activités menées par les entreprises financières et non-financières qui peuvent être classifiées comme « vertes ». Cette forme de derisking réglementaire encourage les entreprises à adapter leurs activités, en leur décernant des « labels verts », sans pour autant punir les investissements polluants. La taxonomie verte fonctionne comme un nudge pour soutenir les investissements durables, dans des secteurs où l’État est présenté comme incapable de procurer l’intégralité des financements.

2021-2027

Le programme InvestEU. Dans l’Union européenne, le programme InvestEU vient remplacer le Fonds européen pour les investissements stratégiques mis en place par le Plan Juncker pour financer des projets d’infrastructure par le derisking. Son objectif est de soutenir la compétitivité de l’UE grâce à des investissements dans des infrastructures durables, innovantes, sociales (éducation, logement, soins de santé, activités culturelles, intégration des personnes vulnérables) ou des PME. Par exemple, le Pacte vert pour l’Europe (European Green Deal), adopté par le Parlement européen en 2020, bénéficie de financements publics mais aussi largement des financements privés mobilisés par InvestEU – dont les objectifs climatiques représenteront au moins 30 % de l’enveloppe financière.

Recevez notre newsletter bi-mensuelle

Parce que résister à la droitisation du monde impose d'abord d'en prendre la mesure.